1. 크롤링 (Web Crawling)

1.1. 정의

크롤링이란 무엇인가?

크롤링은 웹 크롤러 또는 스파이더라고도 불리는 컴퓨터 프로그램을 사용하여 인터넷을 탐색하고 웹 페이지의 정보를 수집하는 프로세스를 의미합니다. 크롤링은 웹상에 존재하는 수많은 웹 페이지를 자동으로 방문하고 그 안에 있는 데이터를 추출하는 작업을 수행합니다. 이러한 데이터 수집은 검색 엔진의 색인 구축, 가격 비교 웹 사이트, 뉴스 집계 등 다양한 목적으로 활용됩니다.

1.2. 동작 원리

크롤러의 작동 방식은 어떻게 되는가?

크롤러는 다음과 같은 단계를 거쳐 웹 페이지를 탐색하고 데이터를 수집합니다.

- 시작 URL 선택: 크롤러는 크롤링을 시작할 초기 URL을 선택합니다. 이 URL은 크롤러가 탐색을 시작하는 지점이 됩니다.

- URL 큐 관리: 크롤러는 시작 URL을 큐에 추가하고, 이후 방문할 URL 목록도 큐에 추가합니다. 이 큐는 크롤러가 다음에 어떤 웹 페이지를 방문할지 결정하는 데 사용됩니다.

- 웹 페이지 방문: 크롤러는 큐에서 다음으로 방문할 URL을 선택하고 해당 웹 페이지로 이동합니다.

- 웹 페이지 내용 수집: 크롤러는 방문한 웹 페이지의 HTML 코드를 가져오고, 웹 페이지 내용에서 필요한 데이터를 추출합니다. 이 작업은 HTML 파싱과 데이터 추출을 통해 이루어집니다.

- 하이퍼링크 추출: 크롤러는 현재 웹 페이지에서 다른 하이퍼링크를 추출하여 큐에 추가합니다. 이렇게 하면 크롤러는 다음에 방문할 웹 페이지를 선택할 수 있습니다.

- 반복: 크롤러는 위의 단계를 반복하면서 계속해서 웹 페이지를 방문하고 데이터를 수집합니다. 이 과정은 크롤러가 설정한 조건에 따라 중단될 때까지 계속됩니다.

1.3. 주요 도구 및 라이브러리

크롤링을 위해 사용되는 주요 도구와 라이브러리는 무엇인가?

크롤링 작업을 수행하기 위해 다양한 도구와 라이브러리가 개발되어 있습니다. 이러한 도구와 라이브러리는 웹 크롤링을 간편하게 수행할 수 있도록 도와줍니다. 주요 크롤링 도구와 라이브러리로는 다음과 같은 것들이 있습니다.

- Requests: HTTP 요청을 보내고 웹 페이지의 내용을 가져오기 위한 파이썬 라이브러리로, 웹 크롤링을 시작하는 데 유용합니다.

- Beautiful Soup: HTML 파싱을 위한 파이썬 라이브러리로, 웹 페이지 내용에서 데이터를 추출하기 위해 사용됩니다.

- Scrapy: 파이썬 기반의 웹 크롤링 프레임워크로, 큰 규모의 크롤링 작업을 효율적으로 수행할 수 있도록 도와줍니다.

- Selenium: 웹 브라우저를 자동으로 제어하여 JavaScript로 렌더링되는 웹 페이지도 크롤링할 수 있는 도구입니다.

- Apache Nutch: 오픈 소스 웹 크롤러로, 대규모 웹 크롤링 및 색인 구축을 위해 사용됩니다.

- Scrapy Cloud: 스크래핑 플랫폼으로, 스크래핑 작업을 클라우드 환경에서 실행하고 관리할 수 있습니다.

- Splash: 렌더링된 웹 페이지를 스크래핑하기 위한 JavaScript 렌더링 서비스로, 복잡한 웹 페이지를 크롤링할 때 유용합니다.

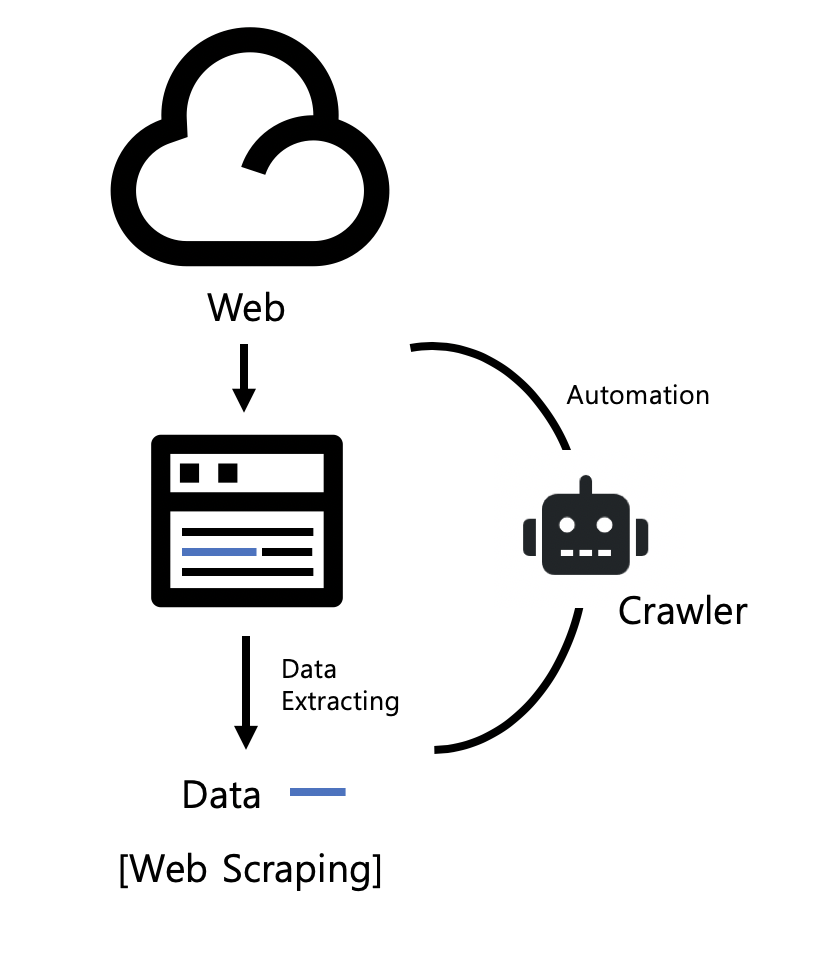

2. 스크래핑 (Web Scraping)

2.1. 정의

스크래핑이란 무엇인가?

스크래핑은 웹 페이지의 내용을 추출하고, 그 데이터를 분석 및 가공하는 프로세스를 의미합니다. 스크래핑은 주로 웹 사이트에서 원하는 정보를 수집하기 위해 사용되며, 이 정보는 일반적으로 텍스트, 이미지, 링크, 테이블 등 다양한 형태로 제공됩니다. 스크래핑을 통해 수집된 데이터는 후속 분석, 보고서 작성, 예측 모델 개발 등 다양한 용도로 활용될 수 있습니다.

2.2. 수행 방법

스크래핑을 위한 일반적인 절차는 어떻게 되는가?

스크래핑 작업은 다음과 같은 일반적인 절차를 따릅니다.

- 대상 웹 사이트 선택: 스크래핑을 수행할 대상 웹 사이트를 선택합니다. 이는 정보를 수집하려는 웹 페이지 또는 사이트의 주소를 결정하는 것을 의미합니다.

- HTTP 요청 보내기: 선택한 웹 페이지에 대한 HTTP 요청을 보냅니다. 이를 통해 웹 서버는 해당 페이지의 내용을 응답으로 전송합니다.

- HTML 데이터 수집: 서버로부터 받은 응답을 기반으로 웹 페이지의 HTML 코드를 추출합니다. 이 코드에는 페이지의 구조와 내용이 포함되어 있습니다.

- 데이터 추출: HTML 코드에서 필요한 정보를 추출합니다. 이 작업은 주로 HTML 파싱과 선택자(query selector)를 사용하여 수행됩니다. 텍스트, 이미지, 링크, 테이블 등 다양한 데이터 형태를 추출할 수 있습니다.

- 데이터 가공 및 저장: 추출한 데이터를 필요에 따라 가공하고 저장합니다. 예를 들어 데이터를 정제하거나 데이터베이스에 저장할 수 있습니다.

- 자동화 및 반복: 필요한 경우 여러 페이지에서 데이터를 수집하기 위해 자동화된 스크립트나 프로그램을 사용하여 스크래핑 작업을 반복합니다.

2.3. 주요 도구 및 라이브러리

스크래핑을 위해 사용되는 주요 도구와 라이브러리는 무엇인가?

스크래핑을 수행하기 위해 다양한 도구와 라이브러리가 사용됩니다. 이러한 도구와 라이브러리는 웹 사이트의 구조를 분석하고 데이터를 추출하는 데 도움이 됩니다. 주요 스크래핑 도구와 라이브러리로는 다음과 같은 것들이 있습니다.

- Beautiful Soup: 파이썬 라이브러리로, HTML 및 XML 문서에서 데이터를 추출하고 파싱하는 데 사용됩니다.

- Scrapy: 파이썬 기반의 웹 스크래핑 프레임워크로, 큰 규모의 스크래핑 작업을 효율적으로 수행할 수 있도록 도와줍니다.

- Selenium: 웹 브라우저를 자동으로 제어하여 JavaScript로 렌더링되는 웹 페이지도 스크래핑할 수 있는 도구입니다.

- Requests: HTTP 요청을 보내고 웹 페이지의 내용을 가져오는 파이썬 라이브러리로, 스크래핑 시작 단계에서 유용합니다.

- XPath: XML 문서에서 데이터를 선택하기 위한 패턴 언어로, 웹 스크래핑에서 특정 요소를 선택하는 데 사용됩니다.

- Puppeteer: Node.js 기반의 라이브러리로, 웹 브라우저를 자동화하여 웹 페이지를 스크래핑하는 데 사용됩니다.

- Regex (정규식): 정규 표현식을 사용하여 특정 패턴의 데이터를 추출하는 데 유용합니다.

3. 크롤링과 스크래핑의 차이점

3.1. 목적

크롤링과 스크래핑의 주요 목적은 무엇인가?

- 크롤링 (Web Crawling):

- 주로 웹 상에서 다양한 웹 페이지를 방문하고 그 내용을 수집하여 검색 엔진의 색인을 구축하는 데 사용됩니다.

- 주로 웹의 구조 및 링크를 탐색하고, 인덱싱을 위한 정보를 수집합니다.

- 데이터의 종류나 형태에 대한 특별한 제한 없이 다양한 웹 페이지를 방문합니다.

- 스크래핑 (Web Scraping):

- 주로 특정 웹 페이지 또는 웹 사이트에서 원하는 데이터를 추출하고 분석하는 데 사용됩니다.

- 주로 웹 페이지의 특정 부분에서 필요한 데이터를 추출합니다.

- 목적에 따라 특정 웹 사이트 또는 웹 페이지의 내용을 대상으로 작업하며, 데이터 추출에 중점을 둡니다.

3.2. 데이터 수집 범위

두 방법 간에 데이터 수집 범위의 차이는 어떤가?

- 크롤링 (Web Crawling):

- 크롤링은 일반적으로 웹 상의 여러 웹 페이지를 방문하며, 대상 웹 페이지의 인덱싱 및 검색을 위한 정보를 수집합니다.

- 크롤링은 웹 페이지의 구조 및 링크를 따라가기 때문에 데이터 수집 범위는 넓고 다양합니다.

- 특정 웹 사이트나 페이지에서 데이터를 추출하는 것이 목적이 아니며, 전체 웹을 대상으로 탐색합니다.

- 스크래핑 (Web Scraping):

- 스크래핑은 주로 특정 웹 페이지 또는 웹 사이트에서 필요한 데이터를 추출하는 것이 목적입니다.

- 스크래핑은 대상 웹 사이트나 페이지에 집중하여 원하는 정보를 수집하므로 데이터 수집 범위는 한정적입니다.

- 특정한 데이터를 추출하고자 하는 목적으로 사용됩니다.

3.3. 자동화 가능성

크롤링과 스크래핑 중 어떤 것이 자동화하기 더 용이한가?

- 크롤링 (Web Crawling):

- 크롤링은 대규모의 웹 페이지를 자동으로 방문하고 인덱싱하기 위한 목적으로 사용되므로 자동화하기에 적합합니다.

- 크롤러는 다양한 웹 페이지를 순차적으로 탐색하며, 일정한 규칙에 따라 자동화된 작업을 수행합니다.

- 스크래핑 (Web Scraping):

- 스크래핑은 특정 웹 페이지 또는 웹 사이트에서 데이터를 추출하고 분석하기 위한 목적으로 사용되므로 자동화하기 어려울 수 있습니다.

- 스크래핑은 웹 페이지의 구조를 이해하고 원하는 데이터를 정확하게 추출하기 위해 세심한 설정과 코드 작성이 필요합니다.

3.4. 데이터 처리

크롤링과 스크래핑 후에 어떻게 데이터를 처리하는가?

- 크롤링 (Web Crawling):

- 크롤링은 주로 웹 페이지의 내용을 수집하고 저장하는 데 중점을 두며, 데이터의 가공 및 분석은 상대적으로 적습니다.

- 주로 검색 엔진에서 검색 결과로 제공되기 위해 인덱싱된 데이터를 제공합니다.

- 스크래핑 (Web Scraping):

- 스크래핑은 웹 페이지에서 추출한 데이터를 가공하고 분석하는 것이 주된 목적입니다.

- 추출한 데이터를 정제하거나 데이터베이스에 저장하고, 분석 및 시각화를 통해 원하는 정보를 도출하는 데 사용됩니다.